THOMAS:TRAJECTORY HEATMAP OUTPUT WITH LEARNED MULTI-AGENT SAMPLING

THOMAS: TRAJECTORY HEATMAP OUTPUT WITH LEARNED MULTI-AGENT SAMPLING

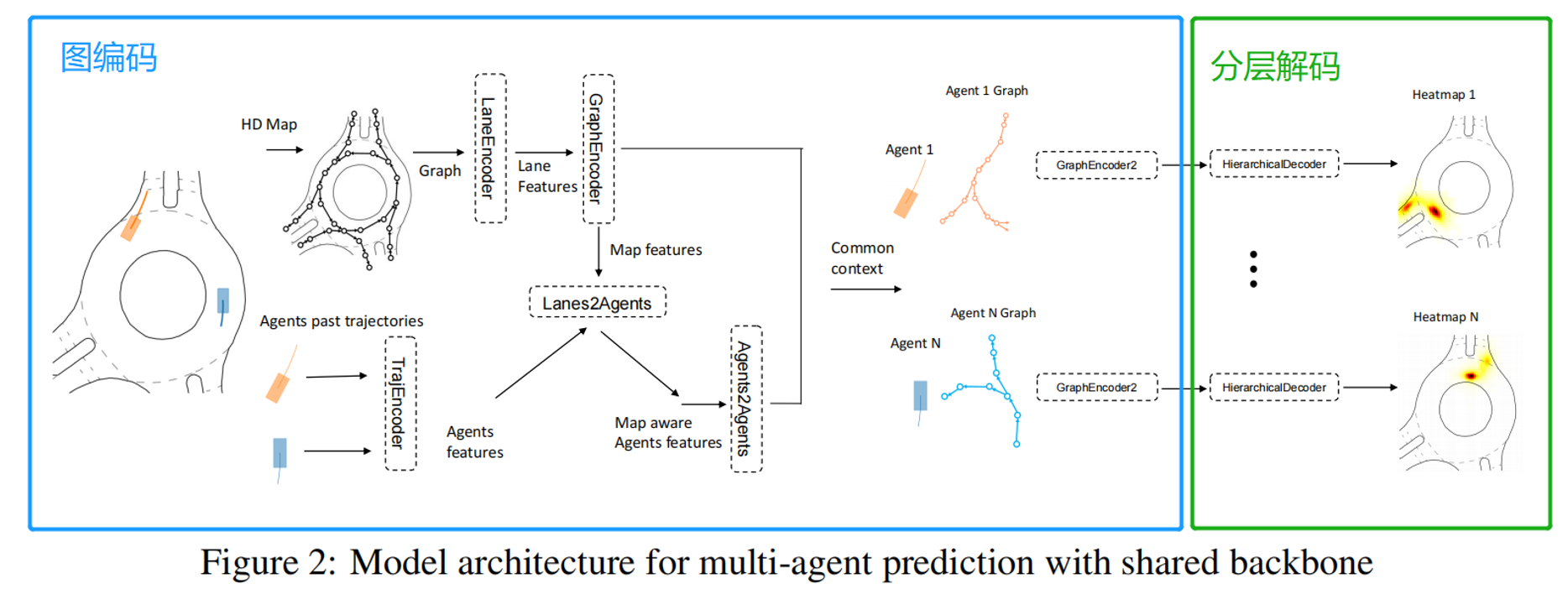

在这篇论文中,作者们提出了一种名为THOMAS的新方法,用于多智能体轨迹预测。这个方法允许有效地、一致地预测多个智能体的多种可能轨迹。为了实现这一目标,他们提出了一个统一的模型架构,用于同时估计各个智能体未来的热图。这个架构利用了分层和稀疏图像生成技术,以实现快速且高效的推断过程。

此外,论文还介绍了一种可学习的轨迹重组模型,它接受每个智能体的一组预测轨迹作为输入,并输出这些轨迹的一致重新排序。这个重组模型的作用是重新组织最初相互独立的轨迹模态,以确保它们不会相互冲突,并保持彼此的一致性。

最终,研究团队在多智能体交互预测挑战赛中取得了非常好的成绩,并在在线测试排行榜上名列第一。这表明他们的方法在多智能体轨迹预测领域取得了显著的进展。

Introduction

Challenge

- The interactivity between agents

- Agents need to be aware of their neighbors in order to adapt their speed, yield right of way and merge in neighbor lanes. To do so, different interaction mechanisms have been developed, such as social pooling graphs or attention , benefiting from the progress of powerful transformer architectures.

- These mechanisms allow agents to look at and share features with neighbors and to take them into account in their own predictions.

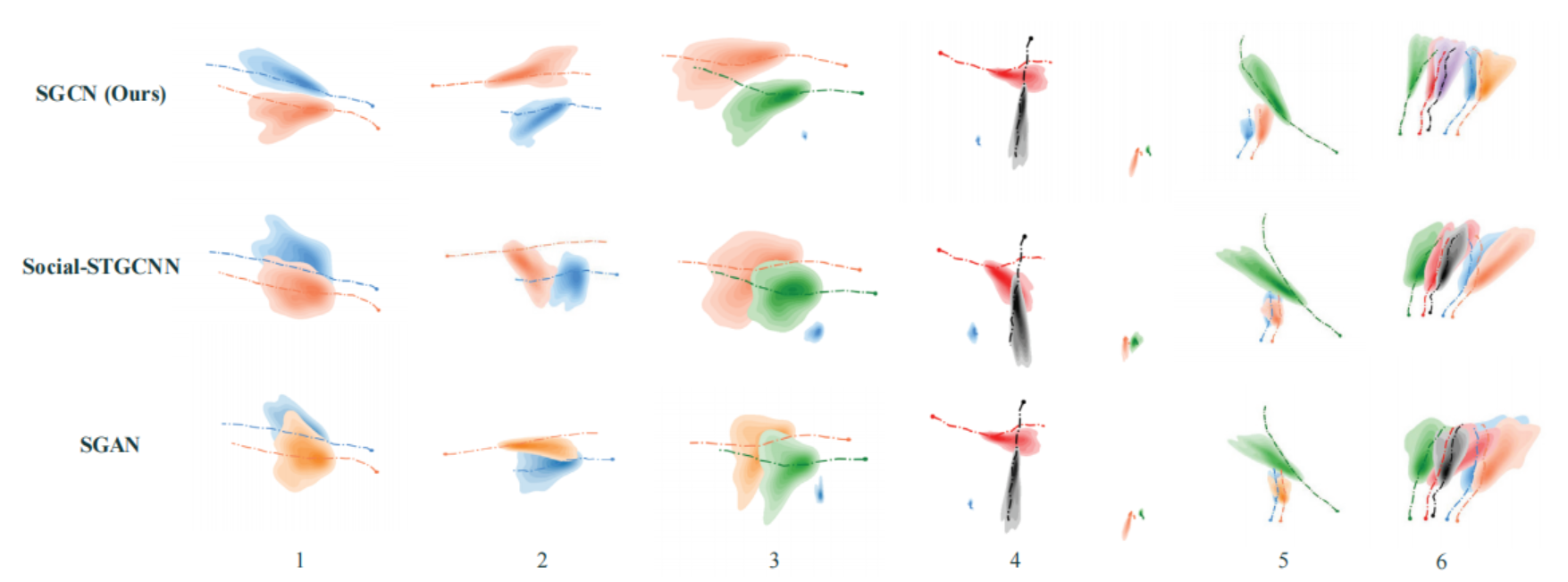

- Multi-modality

- A car can indeed chose to turn right or left, or decide to realise a certain maneuver in various ways.

- Uncertainty modeled as variance of Gaussians is insufficient to model these multiple cases, as it can only represent a continuous spread and cannot show multiple discrete possibilities. (只能代表连续的扩散,不能显示多个离散的可能性。)

- Therefore, current state-of-the-art produces not one but K possible trajectories for each agent predicted, and most recent benchmarks include multimodality in their metrics, taking only the minimum error over a predicted set of K trajectories.

- multi-agent joint interaction challenges

- However, up until very recently and the opening of multi-agent joint interaction challenges no motion forecasting prediction datasets were taking into account **the coherence of modalities between different agents predicted at the same time.**(不同智能体之间模态的一致性)

- As a result, the most probable predicted modality of a given agent could crash with the most probable modality of another agent.

Contributions

- A hierarchical heatmap decoder allowing for unconstrained heatmap generation with optimized computational costs ——–> enabling efficient simultaneous multi-agent prediction

- A novel recombination model able to recombine the sampled endpoints ———–> scene-consistent trajectories across the agents.

Method

目标是使用A个智能体的过去H个时间步和HD-Map上下文,预测未来T个时间步的轨迹。

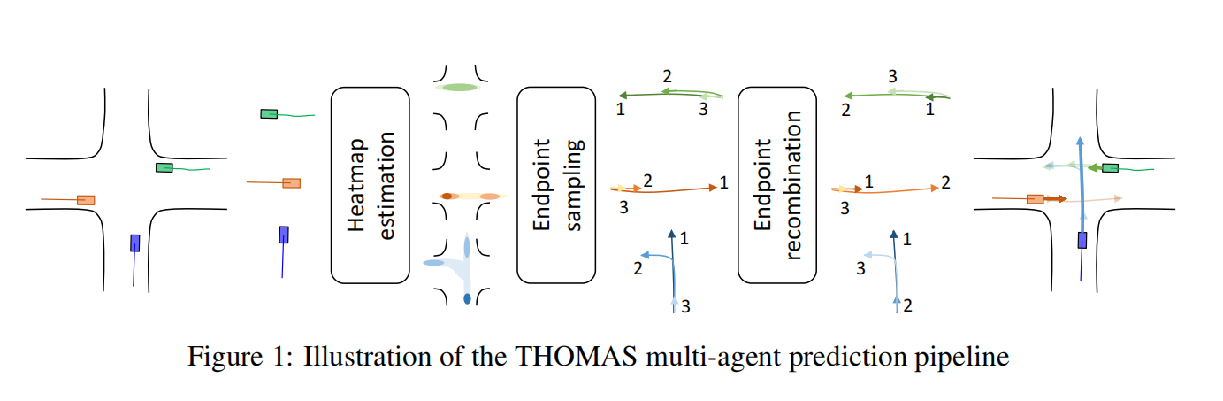

我们将问题分为基于目标的预测,然后是完整轨迹重建。我们的预测流程如图1所示。

首先,我们将每个智能体的轨迹和HD-Map上下文图编码成一个共同的表示。

然后,我们为场景中的每个智能体解码一个未来的概率热图,我们通过启发式方法对其进行采样,以最大程度地覆盖可能性。

最后,我们将采样的终点重新组合成智能体之间的场景一致性模态,并构建每个智能体的完整轨迹。

我们的流程与GOHOME(Gilles等人,2021a)共享相同的图编码器、采样算法和完整轨迹生成,但使用了一种新颖的高效分层热图处理过程,使其能够适用于同时多智能体预测。此外,我们还添加了一个新颖的场景一致性模块,将边缘输出重新组合成联合预测。

MODEL BACKBONE

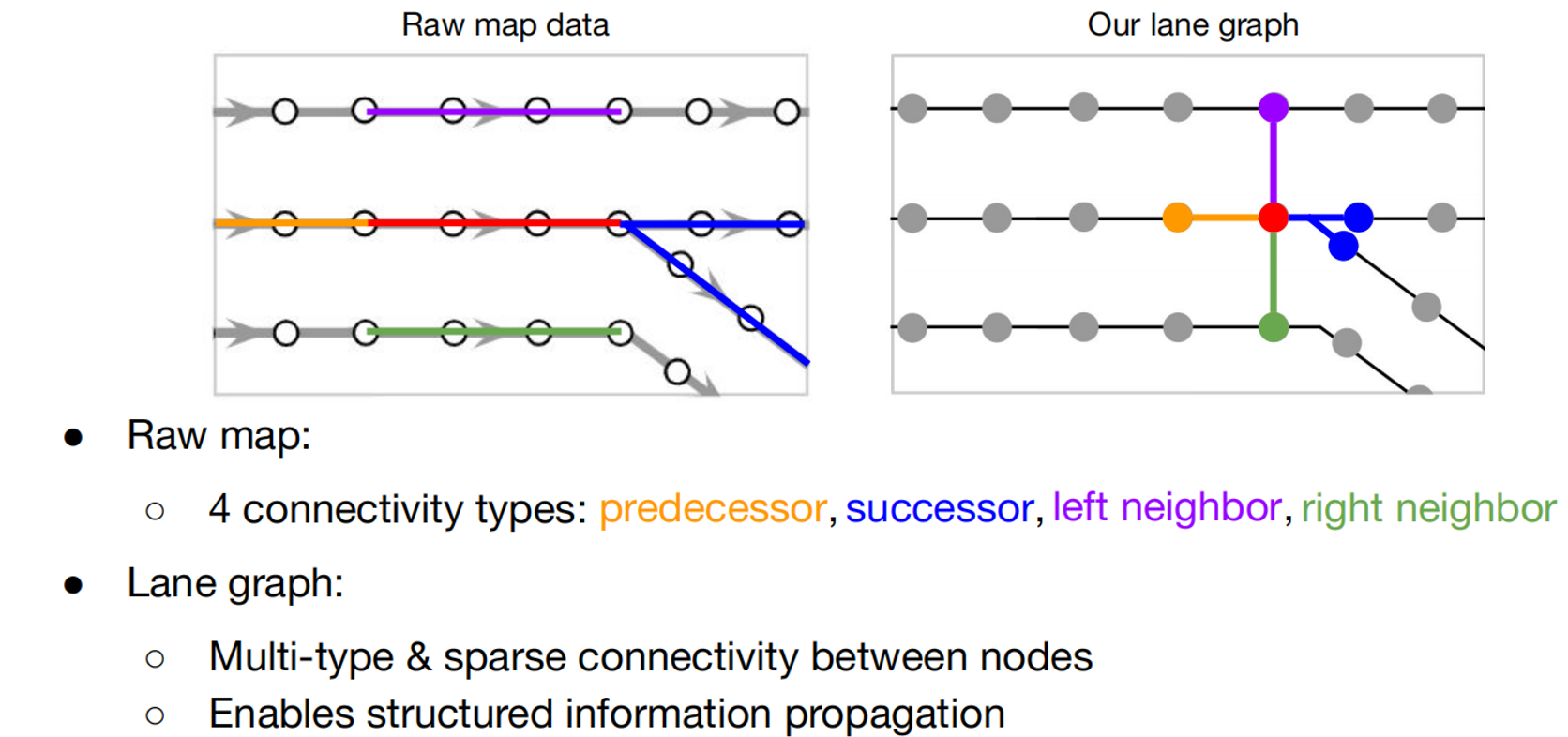

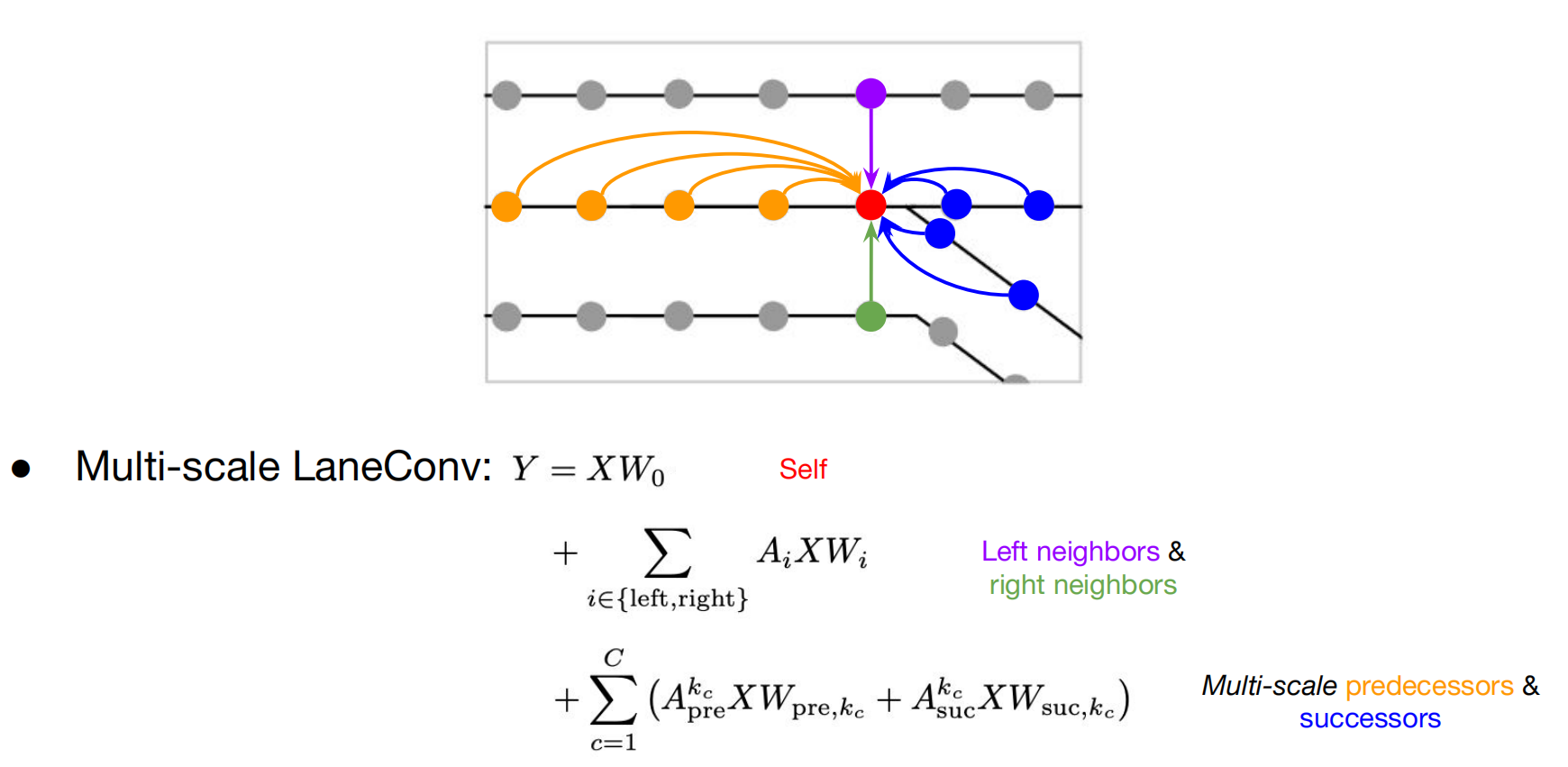

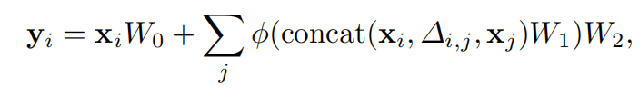

GRAPH ENCODER

We use the same encoder as the GOHOME model

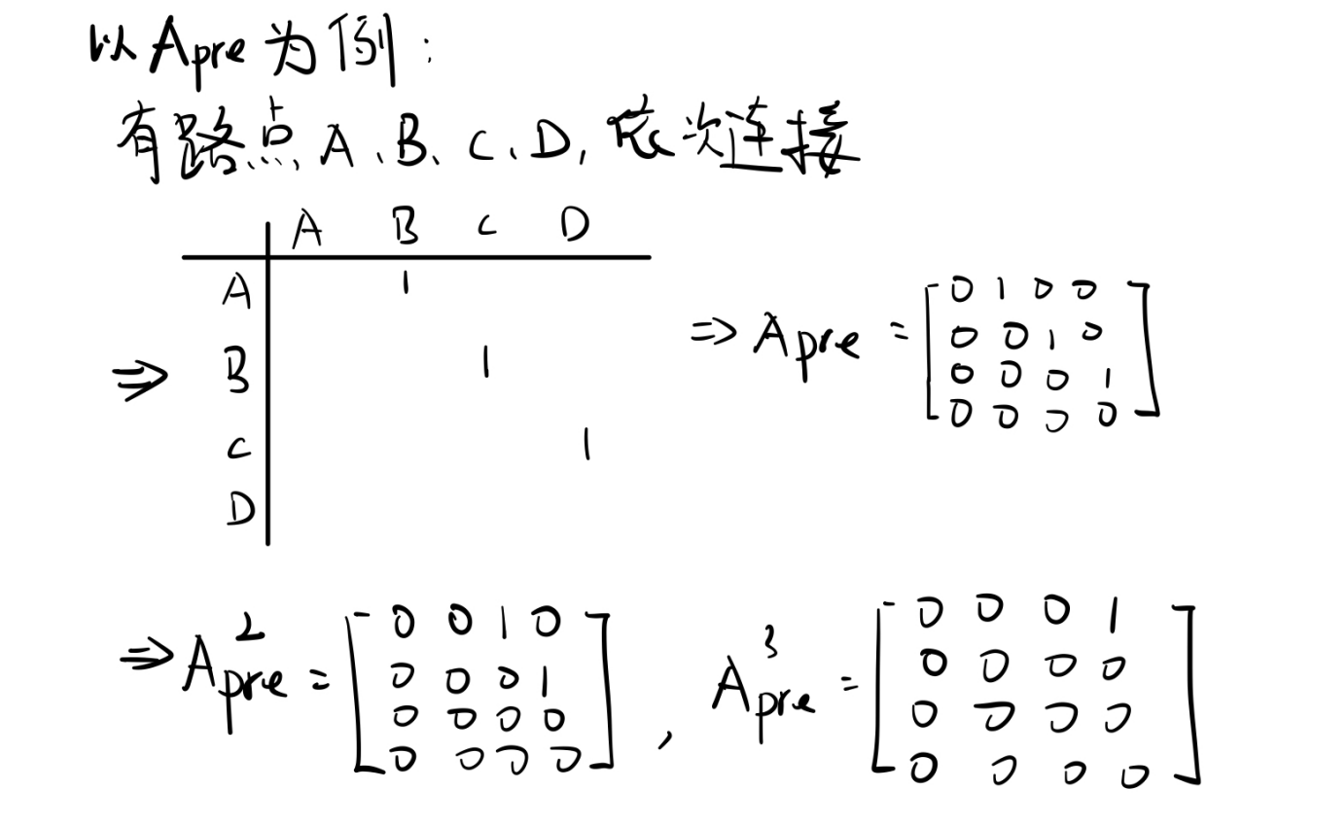

车道编码方式

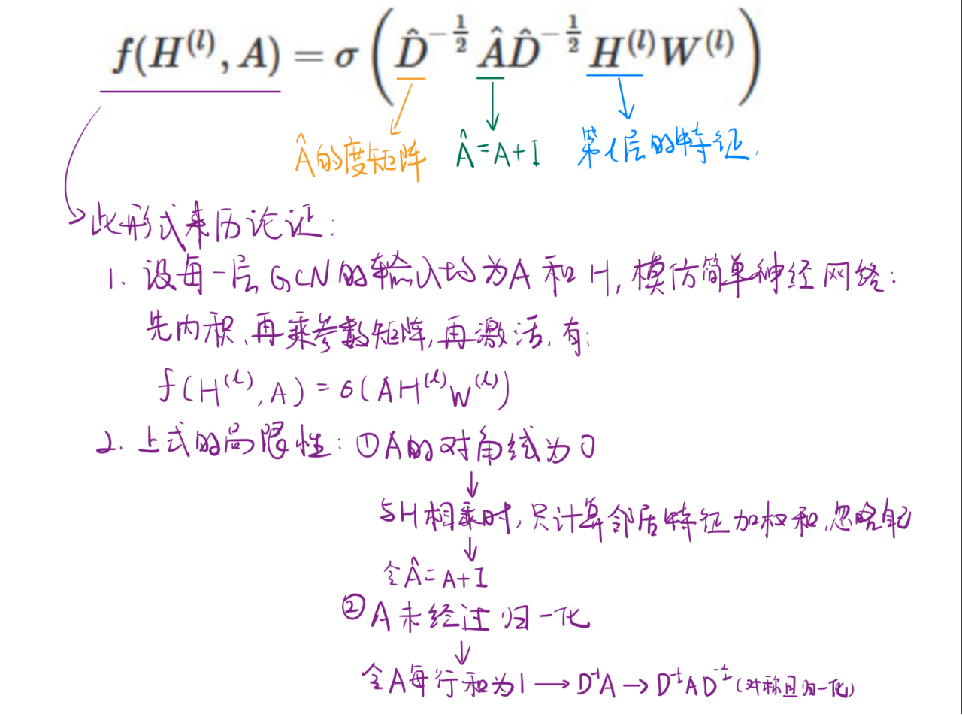

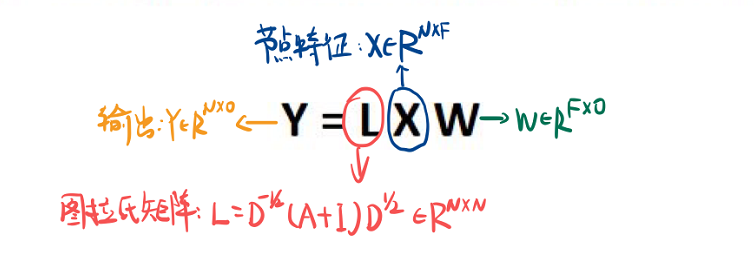

普通图卷积操作:

问题:

1.目前尚不清楚哪种节点特征将保留车道图中的信息

2.单个图拉普拉斯算子无法捕捉连接类型

3.处理长范围依赖关系并不简单

LaneEncoder/GraphEncoder:

Lanes2Agents/Agents2Agents

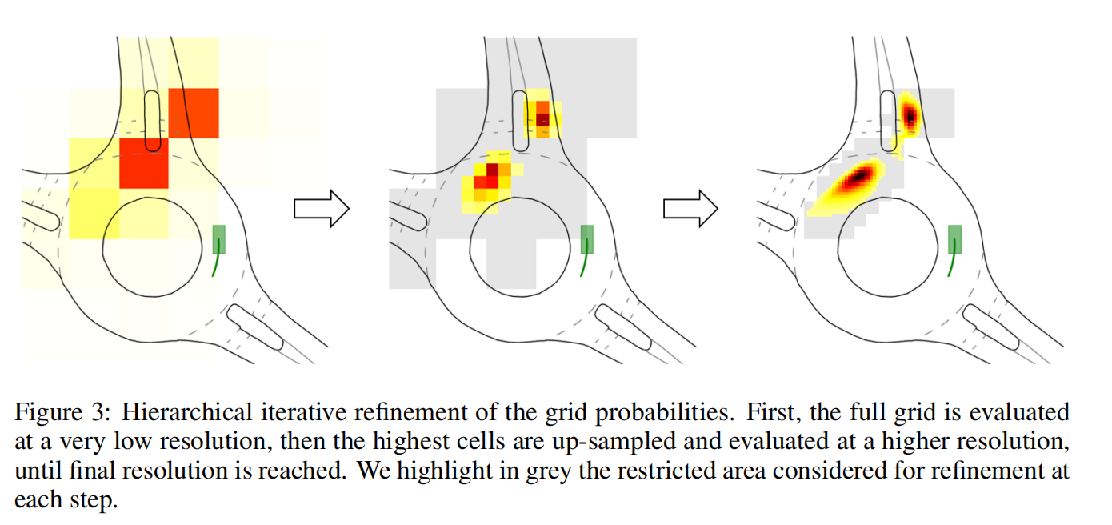

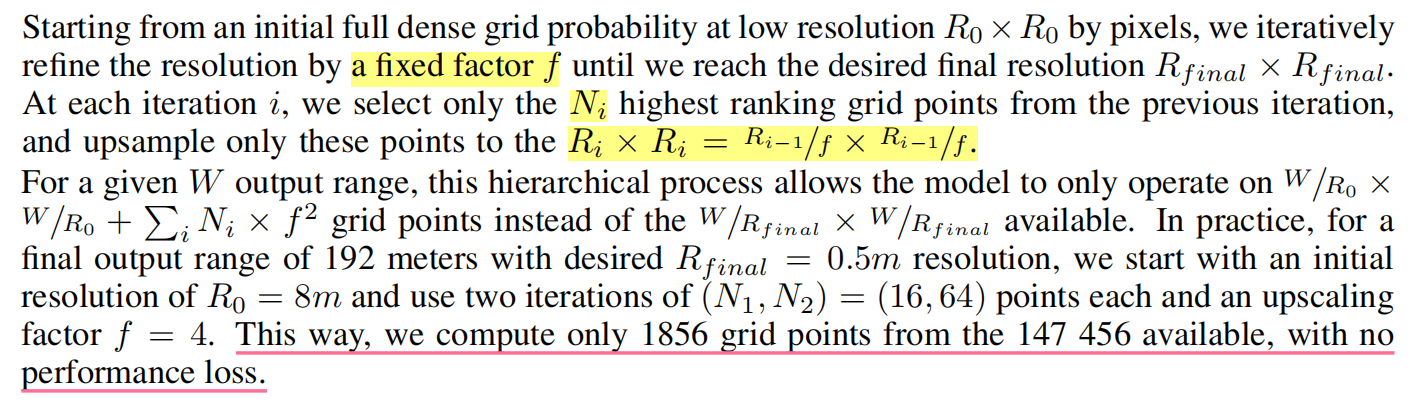

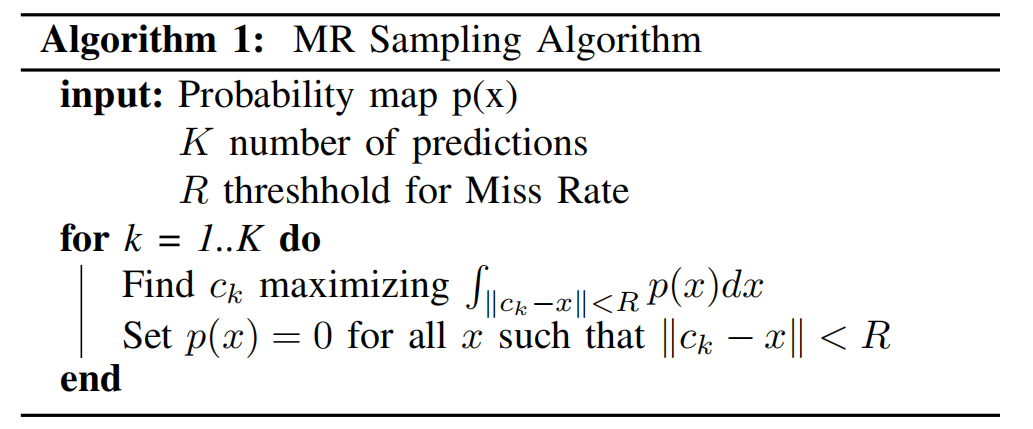

HIERARCHICAL GRID DECODER(分层网格解码器)

- 我们在这里的目的是将每个代理编码解码为热图,热图表示其在预测范围T的未来概率分布。

- 由于我们为场景中的每个代理创建了这个热图,因此解码过程必须快速,以便可以并行应用于大量代理。

- 我们使用不同分辨率级别的分层预测,这样解码器就有可能在代理的整个环境中进行预测,但只有在代理最终很有可能出现的地方,解码器才能学会更精确地进行细化。

- 这种分层过程如图3所示。

FULL TRAJECTORY GENERATION

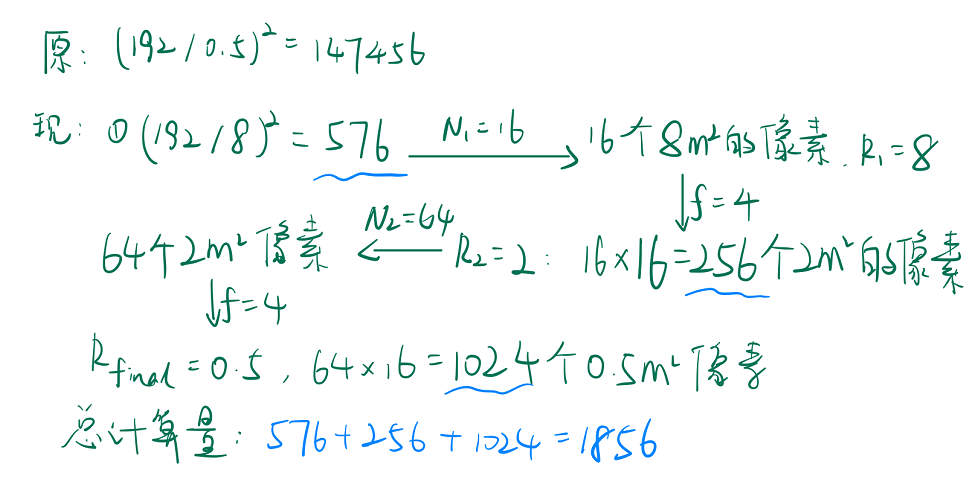

损失函数

热图上每个像素的损失函数为:

注意 : P为关键点数量,Yp为真实值;Y^p为预测值。两者在0~1之间。

对于Yp = 1 : 实际中心点的预测 。

对于简单样本,要适当减少其比重,即loss的值。因此(1-Y^p)2就起到了矫正作用。

对于else(注意:Yp 是由高斯核生成,在中心点Yp = 1,由中心点向周围减少,但不是直接为0)

- 对于距离实际中心点近的点,Yp接近1,假设为0.9 。 但是这种情况下,将Y^p预测值接近1的值是不对的,因为Yp != 1,压根不是中心点,所以用 (Yp-Y^p)2进行惩罚,但由于Yp虽然不是中心点,但是靠的非常近,所以用(1-Yp)4进行补偿。Yp越大,补偿越大。

- 对于距离实际中心点远的点,Yp接近0,假设为0.1 。将Y^p预测值接近1的值更不对,所以用 (Yp-Y^p)2进行惩罚;将Y^p预测值接近0,用(Yp-Y^p)2进行补偿。 对于(1-Yp)4,因为越远(小),比重越大,相当于实际中心周围其他负样本的损失比(即处理正负样本的不平衡)

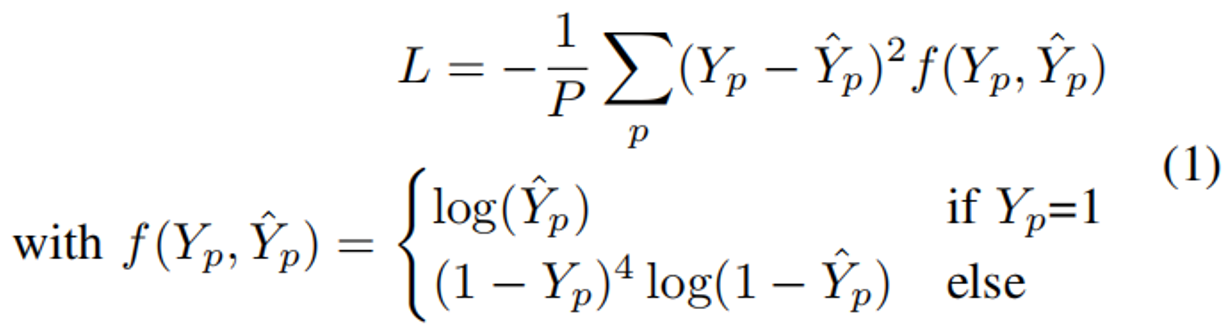

MissRate优化算法

将热图作为输出赋予了我们一个良好的特性,即让我们决定优先覆盖,以便为场景重组过程提供广泛的候选者。

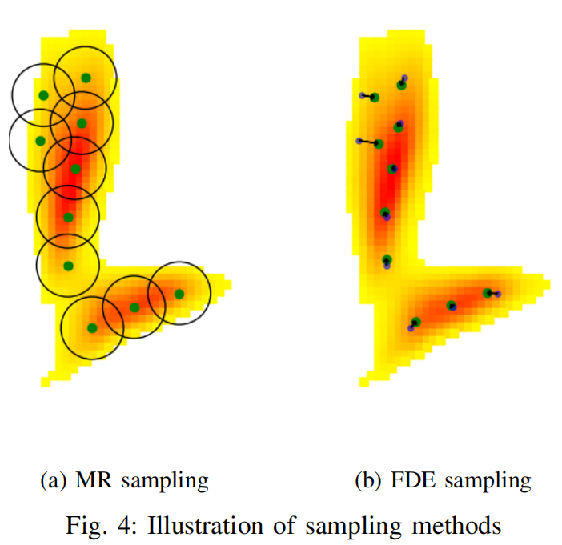

因此,从每个热图中,我们使用MissRate优化算法来解码K个端点。

这是一种比较激进的做法,即一旦找到一个点,就把这个点R米范围之内的点的热图值设为0 。(好处是重叠少、采样距离几乎相同)

采样示意图:

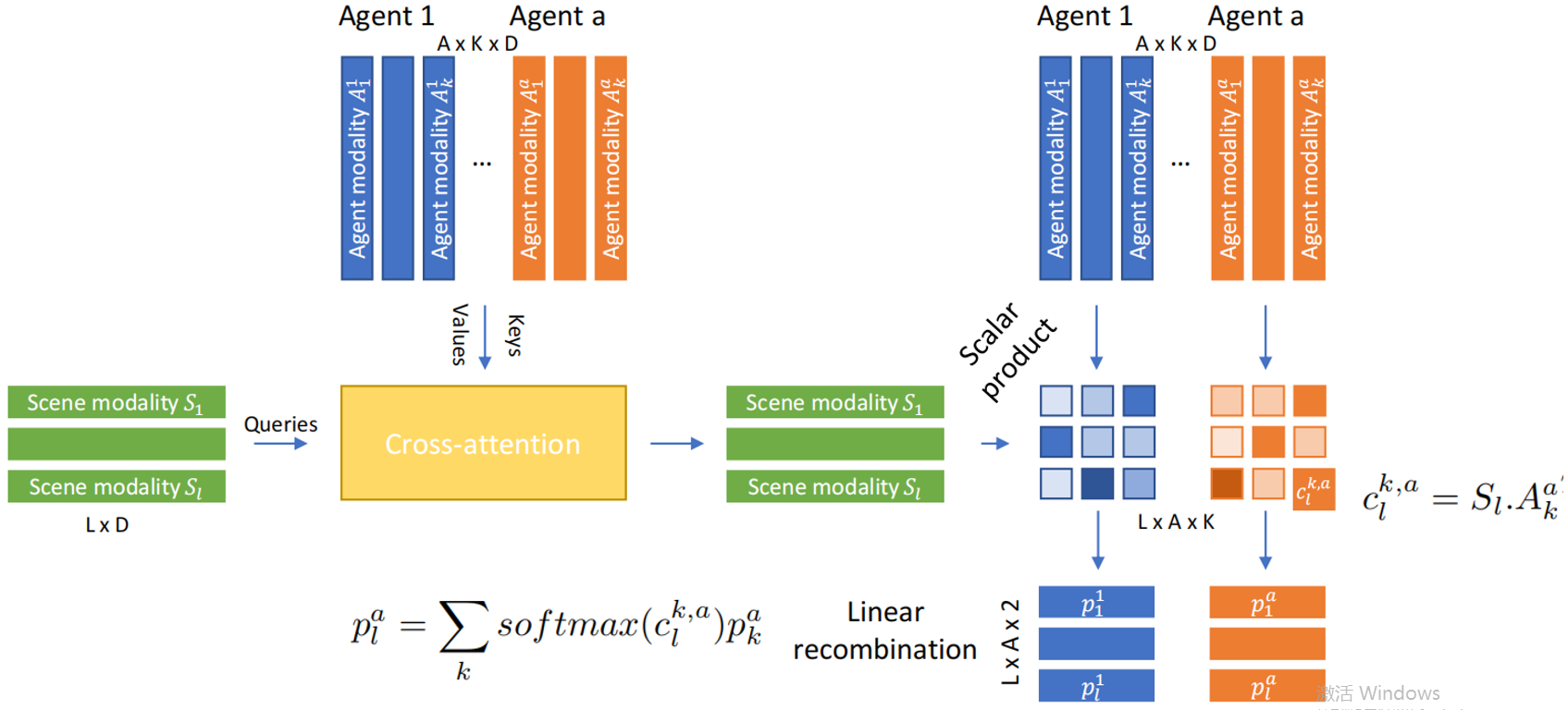

MODALITY RECOMBINATION

多模态多主体预测的困难在于每个主体之间有相干的模式。由于模态被认为是场景的,每个代理的最可能模态必须与其他代理的最可能预测匹配,以此类推。此外,这些模式不能相互碰撞,因为它们应该代表现实的情况。

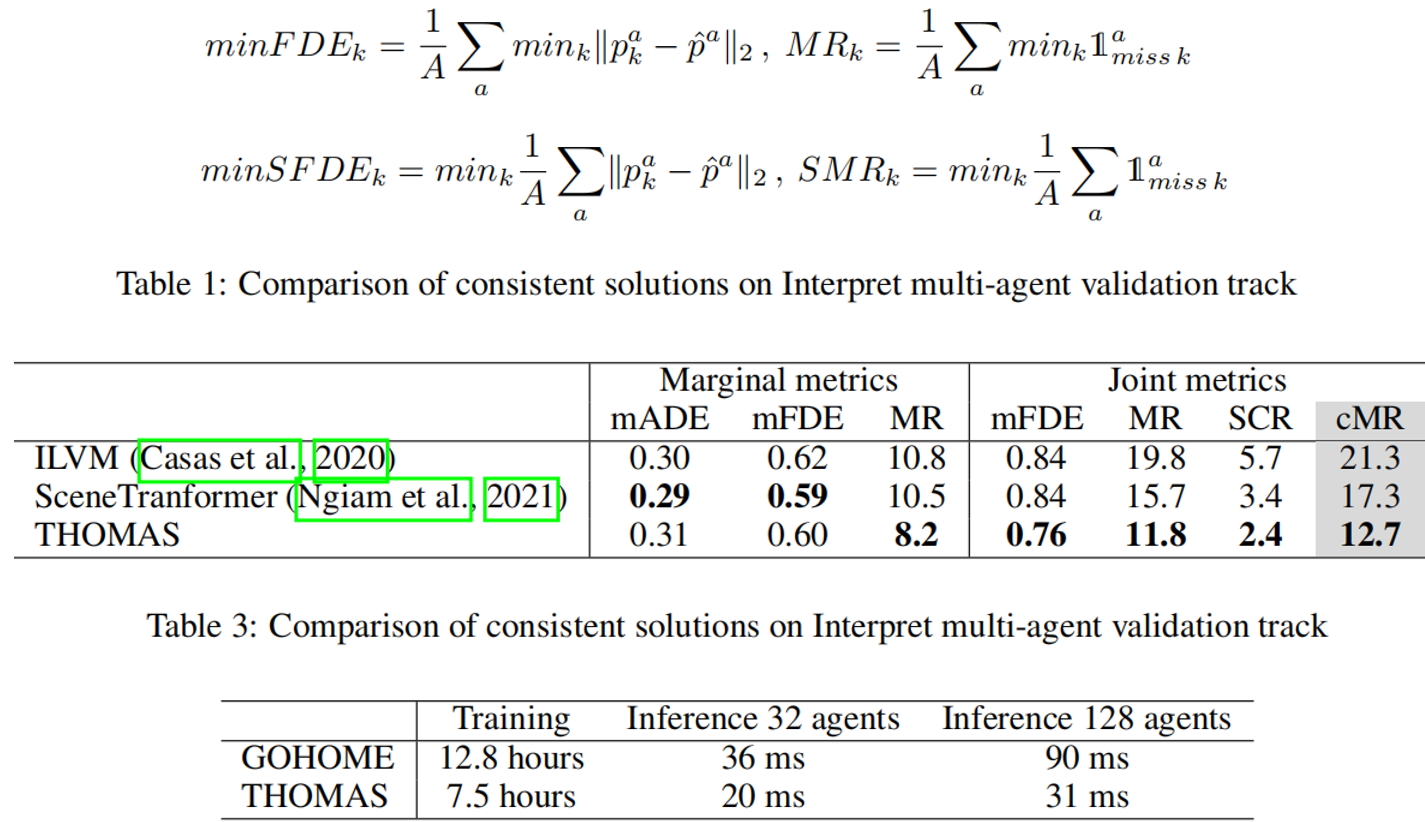

实验

FDE : 先选出每个人最正确的一条轨迹,与其真实轨迹做对比,然后将A个人的差距平均。

SFDE:在多人预测中,平均操作在最小操作之前,即不仅仅考虑每个人的单独的最佳点。换言之,旧的是在K个池中选最优解,而联合度量中,k个池都可能是最优解,因为还要考虑其他人在这一步的损失。